重磅!Spring AI 1.0 正式发布,Java 开发者的 AI神器!

Spring AI 1.0 GA版本终于正式发布!第一个正式版本,超多内容,每个Java开发者都必须了解一下!

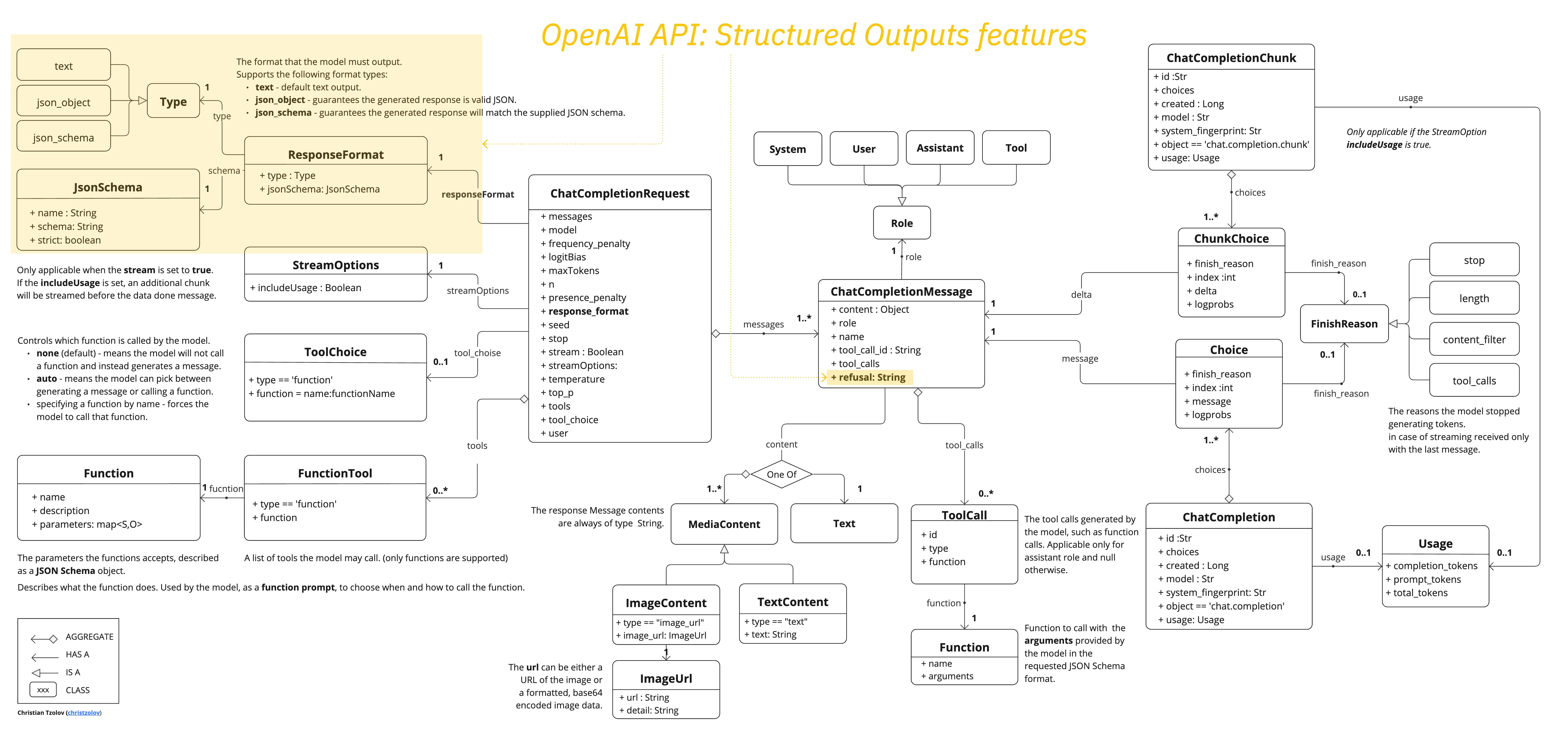

核心功能包括支持20个AI模型的ChatClient接口、适配20个向量数据库的检索模块、支持滑动窗口和向量搜索的对话记忆功能、基于@Tool注解的工具调用机制,以及模型评估、可观测性和Model Context Protocol(MCP)支持。此外,新增RAG流水线、ETL框架、工作流驱动和自主代理功能,并提供与微软Azure、AWS、Google Cloud等云服务商的集成案例。